常有抱怨臉書的個人化演算法,造成臉書牆上只見到自己喜歡的內容,言論越來越單一。最近臉書資料科學團隊的研究成果登上 Science,針對演算法對言論濾泡 (filter bubble) 的現象研究,但被批評在幫自家澄清演算法的負面影響,另外就是研究取樣有問題,聲稱結果能適用全美,但實際上只有 9% 對政治表態的用戶,比例偏低。

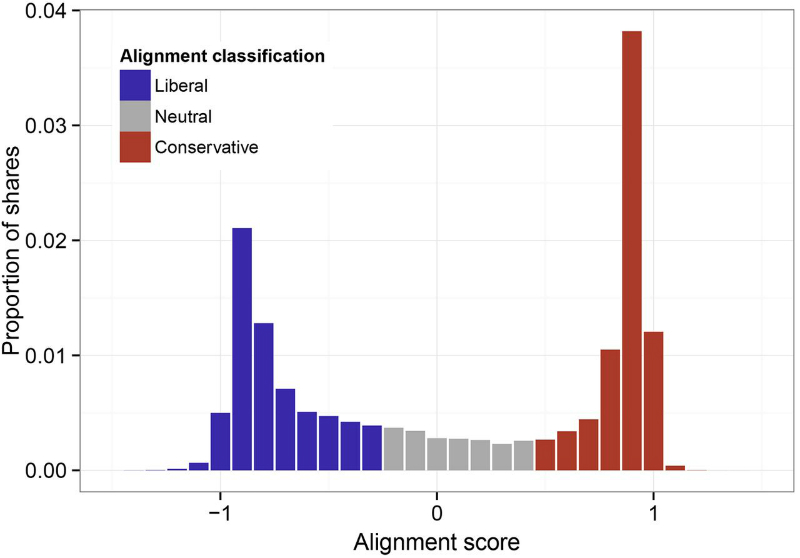

臉書團隊針對美國有填寫政治傾向的臉書用戶,從去年七月開始為期六個月,研究演算法到底會怎麼影響不同想法的用戶。結果臉書資料科學團隊認為個人選擇遠高於演算法造成的影響。儘管演算法會讓自己喜愛的貼文有較高機會出現,但跟自己政治立場相異的貼文仍會出現。演算法對自由派來說,減少 8% 的保守派貼文,對保守派則會減少 5% 自由派貼文。相比之下,使用者的點擊行為對保守派的影響更大,減少 17% 的顯示機會,而自由派則只有 6%。

研究樣本小,並不能推論至全美

臉書的研究團隊指出他們在全美有高達 1,010 萬用戶數量,但由於研究團隊限定有嚴格的四項條件,使得實際運用在統計數的樣本遠低於美國的臉書用戶數量。你必須年滿 18 歲,每週至少登入 4/7 天,必須在牆上分享實驗團隊定議的嚴肅文章,臉書個人檔案的政治傾向必須能夠識別其政黨或是政治立場,不能亂寫。

Our latest data science research, released today in Science, quantifies exactly how much individuals could be and are exposed to ideologically diverse news and information in social media.

Posted by Facebook Data Science on 2015年5月7日

但是臉書的研究成果出爐,被不少人批評,最顯而易見的是研究樣本問題。批評者指出臉書團隊的取樣有問題,有在自己個人資料表態填寫政治傾向的用戶並沒有那麼多。美國的臉書用戶只有 9% 會填寫政治傾向,而其中 54% 是亂寫並不能辨識是保守或是自由派。因此符合條件的用戶只有 4%。一般填寫政治傾向的用戶,比較高的機率在政治上比較活躍。採用只有對政治表態的用戶當樣本,要推論到美國整體情況,會有失真情形。

▲ 保守派、中立派、自由派的臉書用戶,分享的保守、中立、自由派文章比例(圖片來源:Science)

每週 4/7 天登入臉書,則移除 30% 的用戶。要推論到全美 1,010 萬臉書用戶的狀況,其實是不行的。因此西北大學的教授 Eszter Hargittai 批評 Science 雜誌的同儕評審機制出問題,怎麼讓取樣這麼有問題的論文刊出。無法推論到美國的用戶狀況,更何況全球的臉書用戶。而對研究重要的取樣方式,竟然沒有在本文出現,得在補充資料找,容易造成讀論文時解讀錯誤。

臉書讓言論濾泡現象更嚴重

臉書試圖把用戶內容偏食現像,歸究到使用者自己的選擇,有人批評臉書演算法造成的內容單一性,問題遠大過用戶自己的選擇。使用者牆上看到的內容,已經先經過演算法處理過,才顯示出來,這時候再統計用戶會不會看跟自己立場相異的文章,統計上已經偏差了。

這並不是臉書的研究第一次出問題,先前就有操弄使用者的情緒而惹爭議。那次總共有 69 萬用戶涉入而不自知,違反研究論理。

言論濾泡,或者是回音室 (echo chambers) 現像,指是社交網路交流的人常會只聽到跟自己類似想法的論述。指出網路濾泡現像的 Eli Pariser,同時他也是內容農場網站 Upworthy 的創辦人。

臉書讓言論濾泡現象更加嚴重,讓社會上不同聲音減少彼此溝通交流管道,甚至對民主政治造成危機。

(首圖來源:Flickr/7aya net CC BY 2.0)

相關連結

- 論文摘要連結

- 臉書研究部落格文章

- Facebook “filter bubble” study raises more questions than it answers

- Facebook Echo Chamber Isn’t Facebook’s Fault, Says Facebook

- Critics Blast Facebook Study About Effect of Algorithms on Content

- The Facebook “It’s Not Our Fault” Study

- Facebook: Fair and Balanced

- How Facebook’s Algorithm Suppresses Content Diversity (Modestly) and How the Newsfeed Rules Your Clicks

更多關於 瑞霖 陳 的文章 (所有文章)

- Reddit 終於推出自產的官方 App - 2016-04-10

- Google 發佈 Cardboard SDK,方便第三方提供 VR 內容 - 2016-04-01

- Nest 更新加入家庭帳號功能,聰明判斷家裡是否有人 - 2016-03-14